谷歌周二宣布 卢米埃,一个名为“用于真实视频生成的时空扩散模型”的AI视频生成器 随附的预印本。 但我们不要自欺欺人了:它可以很好地在愚蠢的场景中创建可爱动物的视频,例如使用溜冰鞋、驾驶汽车或弹钢琴。 当然,它可以做更多的事情,但它可能是迄今为止最先进的文本到动物人工智能视频生成器。

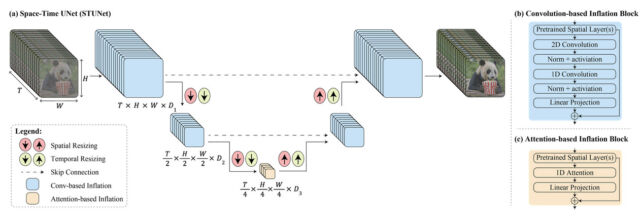

据谷歌称,Lumiere 使用一种独特的结构一次性生成视频的整个持续时间。 或者正如该公司所说:“我们提供时空 U-Net 架构,通过模型中的一次传递,一次性生成视频的完整时间持续时间。这与现有的视频模型形成鲜明对比,现有的视频模型组装了长时长的视频模型。”距离关键帧,然后是超高时间分辨率——“这种方法很难实现全球时间一致性。”

通俗地说,谷歌的技术旨在同时处理空间(事物在视频中的位置)和时间(事物在视频中如何移动和变化)的各个方面。 因此,它不是通过将许多小部分或帧拼接在一起来创建视频,而是可以在一个无缝过程中从头到尾创建整个视频。

谷歌发布的《Lumiere:视频生成的时空扩散模型》文章附带的官方宣传视频。

Lumiere 还可以做很多派对技巧,这些技巧都通过示例进行了很好的阐述 谷歌演示页面。 例如,它可以执行文本到视频的转换(将书面提示转换为视频)、将静态图像转换为视频剪辑、使用参考图像创建特定风格的视频、使用基于文本的提示应用一致的视频编辑,以及创造 电影片段 通过移动图像的特定区域并显示视频 com.inpainting 能力(例如,他们可以改变一个人穿的衣服的类型)。

在 Lumiere 论文中,谷歌研究人员报告称,AI 模型可以生成分辨率为 1024 x 1024 像素的五秒视频,他们将其描述为“低分辨率”。 尽管存在这些限制,研究人员进行了一项用户研究,并声称 Lumiere 的输出优于基于人工智能的视频合成模型。

至于训练数据,谷歌没有透露从哪里获取输入 Lumiere 的视频,只是写道:“我们正在训练我们自己的 T2V 设备。” [text to video] 对包含 3000 万个视频及其文本标题的数据集进行建模。 [sic] 视频长度为 80 帧,帧速率为 16 fps(5 秒)。 基本模型在 128 x 128 上进行训练。”

人工智能生成的视频仍处于初级状态,但过去几年其质量一直在进步。 2022 年 10 月,我们介绍了 Google 首个公开发布的图像合成模型 Imagen Video。 它可以根据每秒 24 帧的键入提示创建 1280 x 768 的短视频,但结果并不总是一致。 在此之前,Meta 推出了自己的 AI 视频生成器 Make-A-Video。 去年6月,Runway的Gen2视频合成模型可以根据文本提示创建两秒的视频,从而创作出超现实的讽刺广告。 11 月,我们介绍了稳定视频扩散,它可以从静止图像创建短片。

人工智能公司经常提供可爱动物的视频生成器,因为目前生成连贯、不失真的人类很困难,特别是因为我们人类(你是人类,对吧?)善于注意到人们身体的任何缺陷或他们的移动方式。 看看人工智能生成的威尔·史密斯吃意大利面就知道了。

从谷歌的例子来看(我们自己没有使用它),Lumiere 似乎优于其他人工智能驱动的视频创作模型。 但由于谷歌倾向于将其人工智能研究模型保密,我们不确定公众何时有机会亲自尝试。

一如既往,当我们看到文本到视频合成模型变得越来越强大时,我们不禁会想…… 未来的影响 对于我们的在线社会来说,这一切都是为了共享媒体元素,并且普遍认为“真实”视频通常代表摄像机捕捉到的真实情况中的真实事物。 Lumiere 未来功能更强大的视频合成工具将使创建欺骗性的深度赝品变得极其容易。

为此,研究人员在卢米埃尔论文的“社会影响”部分写道:“我们这项工作的主要目标是让新手用户能够以创造性和灵活的方式创建视觉内容。 [sic] 然而,使用我们的技术存在滥用创建虚假或有害内容的风险,我们认为有必要开发和实施工具来检测偏见和有害用例,以确保安全和公平使用。

More Stories

《东京恶习》制片人详述日本走向全球制作中心之路

康拉德·科尔曼仅使用可再生能源再次改变了世界

新款 MacBook Pro 为苹果一周的重大新闻画上了句号